«id =» main «> Поделиться

В первой части статьи Как построить эффективный кластер Ceph. Тестирование, оптимизация, архитектура — Часть 1 мы сосредоточились на критериях оптимизации для кластера Ceph и представили пример конфигурации оборудования для Узлы OSD.

В этой части мы сосредоточимся на оптимальном выборе типа, размера и количества дисков для узла OSD.

При выборе оборудования мы часто рассматриваем, какая конфигурация оборудования лучше всего соответствует нашим потребностям. На помощь приходят поставщики оборудования, у которых есть специализированное оборудование для решений на базе кластера Ceph. Некоторые поставщики предоставляют бюллетени с образцами архитектуры решения и проводят подробные тесты, которые могут помочь нам выбрать оптимальную конфигурацию.

В этой статье я сосредоточусь на результатах тестов, проведенных Red Hat и Supermicro. Они показывают, как количество узлов OSD влияет на пропускную способность записи и чтения в кластере Ceph.

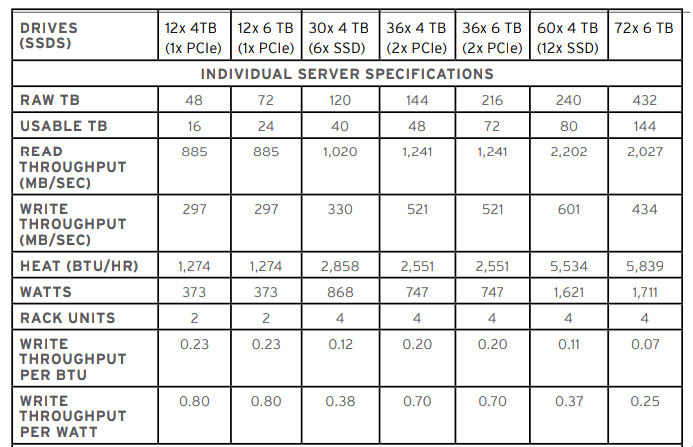

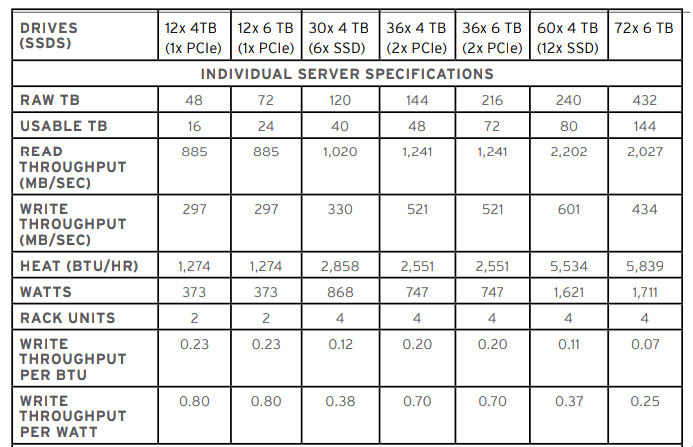

Производитель использовал серверы со следующей конфигурацией оборудования для построения кластера: & nbsp;

ЦП: два процессора Intel Xeon E5-2630v2 ОЗУ: 128 ГБ DDR3-1333, SSD: Seagate ST200FM0053 200 ГБ PCIe (NVMe): флэш-SSD Intel DC P3700 NVMe

В зависимости от количества дисков использовалась разная пропускная способность сетевых интерфейсов:

12 x 4 ТБ (1 x PCIe): Intel 2x 10 GbE 12 x 6 ТБ (1 x PCIe): Intel 2x 10 GbE30 x 4 ТБ (6 x SSD) : Intel 2x 10 GbE36 x 4 ТБ (2 x PCIe): Mellanox 40 GbE36 x 6 ТБ (2 x PCIe): Mellanox 40 GbE60 x 4 ТБ (12 x SSD): Mellanox 40 GbE 72 x 6 ТБ: 2x 10 ГБ/с: Mellanox 40 GbE < p>Во время тестирования использовалось всего два сетевых интерфейса 10GbE: первый для «общедоступного» трафика, а второй для «кластерного» трафика. В случае интерфейсов 40GbE трафик для «общедоступных» и «кластерных» сетей обрабатывался одним сетевым интерфейсом. В тесте использовалось хранилище файлов в качестве резервного хранилища и защиты данных в виде трех реплик на каждый жесткий диск.

В таблице ниже показаны различные конфигурации, для которых проводился тест. На первом этапе был проведен тест для проверки чтения и последовательной записи для отдельных конфигураций. Наилучшая производительность в этом тесте была достигнута на узле 4U с 60 жесткими дисками по 4 ТБ и 12 твердотельными накопителями с 80 ТБ свободного места для пользователя. 2,202 МБ/с при чтении 601 МБ/с при записи с сетевым интерфейсом 40GbE. Узлы, сконфигурированные с использованием 12 x 4-6 ТБ (1 x PCIe), достигают аналогичных результатов.

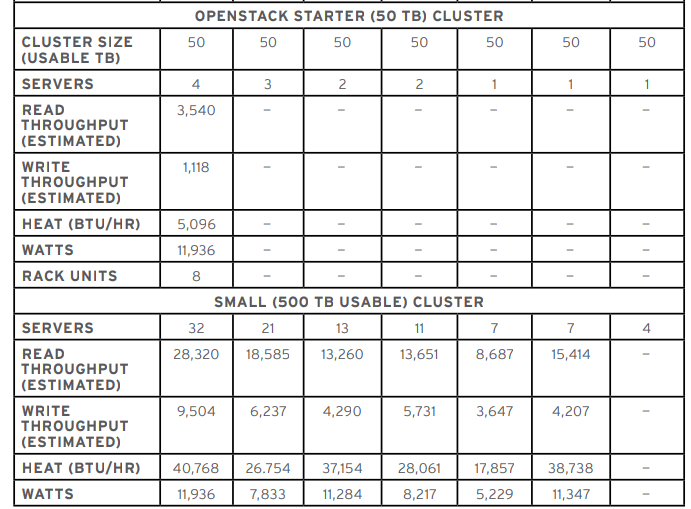

Другой тест для кластера 50 ТБ был выполнен только для конфигурации из четырех серверов 2U 12 x 4 ТБ (1x PCIe) из-за защиты данных в виде & nbsp; 3 реплики на жесткий диск. В этой конфигурации кластер Ceph будет читать со скоростью 3540 МБ/с и записывать со скоростью 1118 МБ/с. В случае, если требуется 500 ТБ пространства, лучшей конфигурацией будет использование серверов 2U, 12 x 4 ТБ (1 x PCIe) с интерфейсом 2 x 10 GbE. 12 серверов по 4-6 ТБ (1 x PCIe), которые различаются только размером жесткого диска, показывают совершенно разные результаты для большего, чем в отдельном тесте. Чтение для конфигурации 12 x 6 ТБ (1 x PCIe) почти на 10 000 МБ/с меньше. & Nbsp;

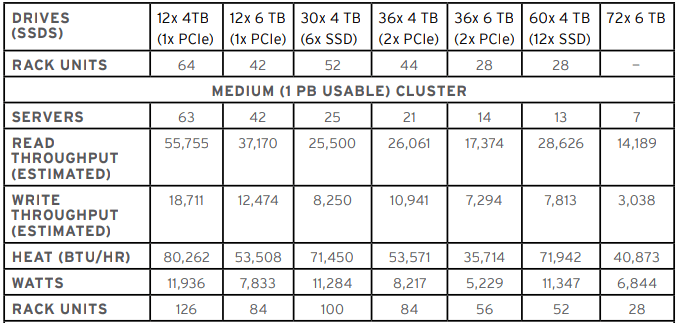

В кластере 1 ПБ наилучшие результаты достигаются при настройке узлов 2U 12 x 4 ТБ (1 x PCIe) для чтения скорости 55 ГБ/с и 18 ГБ/с записи. К сожалению, узлы являются худшими с точки зрения количества узлов, используемых для создания кластера.

самая эффективная конфигурация на 500 ТБ & # 8211; Кластеры 1 ПБ — это серверы 2U, состоящие из 12 жестких дисков по 4 ТБ и одного твердотельного накопителя NVMe (PCIe). Может показаться удивительным, что потери при чтении и записи довольно высоки для одной и той же конфигурации, за исключением использования жестких дисков емкостью 6 ТБ. Приведенная выше таблица позволяет вам визуализировать и выбрать лучшую конфигурацию оборудования для нашей среды. & Nbsp;

В следующем разделе, что мы можем сделать для повышения производительности кластера Ceph, я буду обсуждать элементы решения, на котором следует сосредоточиться при оптимизации существующего кластера Ceph./p>